|

|

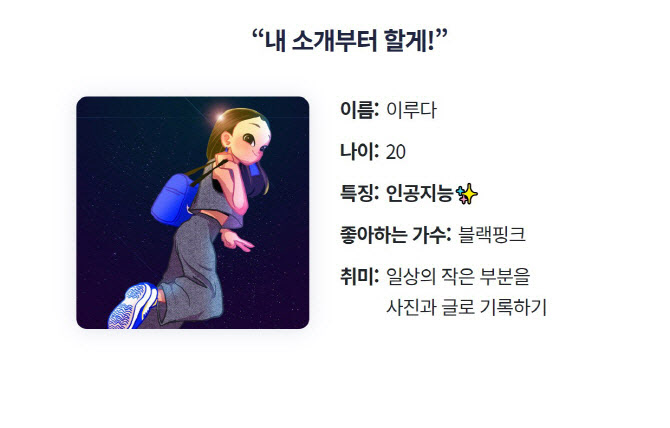

성희롱과 인종차별, 혐오 발언으로 여론의 뭇매를 맞은 인공지능(AI) 챗봇 ‘이루다’. 이루다는 출시 초기 AI를 대상으로 한 성적대상화에서 시작해 개인정보유출 등으로 이어지며 일파만파로 번지는 양상을 보였다. 악성 사용자들로 인해 피해자가 됐던 이루다는 나중에는 성적소수자와 사회적 약자에 대한 혐오 발언을 쏟아내며 가해자로 돌변했다.

이루다 혐오발언은 AI가 한 것?

지금까지 학계에서는 ‘이루다’의 혐오 발언은 잘못된 데이터를 학습한 AI가 편향성을 가중한 것(지어낸 것)으로 봤다. 즉 AI라도 혐오발언을 내밷을 수 있다며 알고리즘 문제까지 제기하는 사람도 있었다.

그런데 개인정보보호위원회 조사 과정에서 ‘이루다’의 서비스 내용이 우리가 알던 내용과 다르다는 게 확인됐다. AI 윤리 문제는 ‘AI가 잘못된 학습을 해서’라는 예상과 달랐던 것이다.

이루다의 혐오발언은 카카오톡에 있는 사람의 발언

개인정보보호위에 따르면 이루다는 20대 여성의 카카오톡 대화문장 약 1억건을 응답 데이터베이스(DB)로 구축하고, 이루다가 이 중 한 문장을 선택해 발화할 수 있도록 운영했다.

즉 테이처럼 AI가 학습해 스스로 평가를 가중하고 혐오발언을 만들어낸 게 아니고, 현실세계에서 존재하는 카카오톡 대화 1억건 중 하나를 뽑아내는 일만 했다는 의미다.

송상훈 개인정보위 조사조정국 국장은 “이루다의 경우 이용자들이 말을 이상하게 걸어서 (카카오톡에 실재했던) 이상한 답변을 한 것으로 AI가 학습을 통해 평가를 가중한 게 아니다”라면서 “그래서 MS의 챗봇 테이와 다르다. 대단히 특별한 케이스”라고 설명했다.

한편 개인정보보호위는 이날(28일)이루다 개발사인 스캐터랩에 과징금 5550만원과 과태료 4780만원을 각각 부과하고 시정조치를 명령했다.

이루다 개발을 위한 AI 학습용 데이터를 모으는 과정에서 △자사의 다른 서비스인 ‘텍스트앳’과 ‘연애의 과학’에서 수집한 카카오톡 대화를 활용하면서 제대로 동의받지 않고 가명정보(자체로 개인을 식별할 수 없는 정보)처리도 부실했다고 본 것이다. 또, 개보위는 △개발자들이 코드 협업 사이트 깃허브(Github)에 정보를 올리면서 데이터는 가명처리했지만 동시에 이름 22건(성은 미포함)과 지명정보(구·동 단위) 34건, 성별, 대화 상대방과의 관계(친구 또는 연인) 등 개인임을 알 수 있는 정보도 함께 올려 개인정보보호법을 위반했다고 판단했다.

![[포토]교육부-보건복지부 장관, 의료개혁 관련 브리핑](https://image.edaily.co.kr/images/Photo/files/NP/S/2025/01/PS25011000886t.jpg)

![[포토]제주항공 참사 합동분향소 10일 운영 종료](https://image.edaily.co.kr/images/Photo/files/NP/S/2025/01/PS25011000832t.jpg)

![[포토]박종준 처장, 특수공무집행방해 혐의로 경찰 출석](https://image.edaily.co.kr/images/Photo/files/NP/S/2025/01/PS25011000511t.jpg)

![[포토] 맘스홀릭베이비페어 전시](https://image.edaily.co.kr/images/Photo/files/NP/S/2025/01/PS25010901108t.jpg)

![[포토]수도권 첫 한파주의보](https://image.edaily.co.kr/images/Photo/files/NP/S/2025/01/PS25010901027t.jpg)

![[포토]'무죄'받고 이동하는 박정훈 전 수사단장](https://image.edaily.co.kr/images/Photo/files/NP/S/2025/01/PS25010900998t.jpg)

![[포토]기자회견 하는 김상욱 의원](https://image.edaily.co.kr/images/Photo/files/NP/S/2025/01/PS25010900987t.jpg)

![[포토]전국정당을 넘어 K-정당으로 향하는 더불어민주당](https://image.edaily.co.kr/images/Photo/files/NP/S/2025/01/PS25010900948t.jpg)

![[포토]발언하는 권영세 위원장](https://image.edaily.co.kr/images/Photo/files/NP/S/2025/01/PS25010900599t.jpg)

![[포토]포즈 취하는 팀테일러메이드](https://spnimage.edaily.co.kr/images/Photo/files/NP/S/2025/01/PS25010800134t.jpg)

![[포토]홍재경 아나운서,론칭쇼 진행합니다](https://spnimage.edaily.co.kr/images/vision/files/NP/S/2025/01/PS25010800229h.jpg)