|

노용만 교수 연구팀은 단순히 모델의 크기를 키우거나 고품질의 시각적 지시 조정 데이터셋을 만들지 않고 멀티모달 대형언어모델의 시각 성능을 높인 콜라보(CoLLaVO), 모아이(MoAI) 2가지 기술을 개발했다.

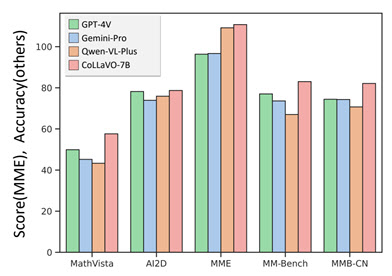

연구팀이 개발한 첫 번째 기술인 ‘콜라보(CoLLaVO)’는 현존 공개형 멀티모달 대형언어모델이 비공개형 모델의 성능에 비해 낮은 이유를 이미지 이해 능력이 떨어진다는 것에서 찾았다.

|

시각적 지시 조정 단계에서 학습한 정보를 잃어버리지 않기 위해 연구팀은 물체 수준 이미지 이해 능력과 시각·언어 업무 처리 능력을 서로 다른 측정지표로 학습해 서로 간 정보를 잃지 않게 만드는 학습 전략인 ‘듀얼 큐로라(Dual QLoRA)’도 제안했다.

노용만 교수는 “이번에 개발한 공개형 멀티모달 대형언어모델이 ‘허깅페이스 일간 화제의 논문’에 추천됐고, 각종 SNS를 통해 세계 연구자에게 알려지고 있다”며 “모든 모델을 공개형 대형언어모델로 출시했기 때문에 앞으로 멀티모달 대형언어모델 발전에 기여할 것”이라고 말했다.

한편, 콜라보(CoLLaVO)는 자연어 처리(NLP) 분야 국제 학회 ‘인공지능언어학회(ACL Findings) 2024’에 지난 달 16일자로 학회에 승인받았다. 모아이(MoAI)는 컴퓨터 비전 국제 학회인 ‘유럽 컴퓨터 비전 학회 2024’ 승인을 앞두고 있다.

![[포토] 이재경 '핀하이로 쏜다'](https://spnimage.edaily.co.kr/images/Photo/files/NP/S/2024/10/PS24100400197t.jpg)

![[포토] 축시 낭독](https://image.edaily.co.kr/images/Photo/files/NP/S/2024/10/PS24100400720t.jpg)

![[포토] 2024 세계한인회장대회](https://image.edaily.co.kr/images/Photo/files/NP/S/2024/10/PS24100400598t.jpg)

![[포토]유현조,나이스 마무리 퍼트](https://spnimage.edaily.co.kr/images/Photo/files/NP/S/2024/10/PS24100400048t.jpg)

![[포토]박도은,핀 공략을 생각한다](https://spnimage.edaily.co.kr/images/Photo/files/NP/S/2024/10/PS24100300270t.jpg)

![[포토]"예쁜 피부는 역시" 엘렌실라, W페스타 부스 운영](https://image.edaily.co.kr/images/Photo/files/NP/S/2024/10/PS24100300485t.jpg)

![[포토]전국 의대 교수, '의평원 무력화 막을 것'](https://image.edaily.co.kr/images/Photo/files/NP/S/2024/10/PS24100300350t.jpg)

![[포토]부천국제만화축제 참가한 부천대학교 학생들](https://image.edaily.co.kr/images/Photo/files/NP/S/2024/10/PS24100300332t.jpg)

![[포토]파란하늘과 가을 꽃](https://image.edaily.co.kr/images/Photo/files/NP/S/2024/10/PS24100300310t.jpg)

![[포토]개천절 경축식 만세삼창](https://image.edaily.co.kr/images/Photo/files/NP/S/2024/10/PS24100300275t.jpg)

![[포토]박성현,언니 결혼 축하해주세요](https://spnimage.edaily.co.kr/images/Photo/files/NP/S/2024/10/PS24100400670t.jpg)

![24시간 쫓고 또 쫓는다…'무도실무관' 김우빈의 쏜살같은 차는[누구차]](https://image.edaily.co.kr/images/Photo/files/NP/S/2024/10/PS24100500206t.jpg)

![이재명 입에 '56兆 금투세 폐지' 달렸다…결단 언제[증시 핫피플]](https://image.edaily.co.kr/images/Photo/files/NP/S/2024/10/PS24100500247b.jpg)

![기네스 기록 경신한 '중국 드론쇼' 무서운 이유[우주이야기]](https://image.edaily.co.kr/images/Photo/files/NP/S/2024/10/PS24100500267b.jpg)