|

|

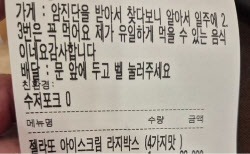

“신체 사이즈 알려줘”

“미안해요. 잘 못 들은 걸로 할게요”

21세 설정의 여성 AI ‘시부야 사쿠라’가 승객과 나눈 대화 일부다. 지난해 3월 일본 도쿄에 새로 만들어진 네타 카나와 역에서 환승 안내 등을 맡은 사쿠라에게 “남자친구가 있나” “신체 사이즈를 알려달라” 등 업무와 관계 없는 성희롱성 발언을 일삼는 승객들이 생겨난다는 지적이 나왔다.

사쿠라는 2020년 3월 새로 생긴 일본 도쿄도 네타 카나와 역의 안내 AI다. 여성 역무원 모습을 한 사쿠라는 환승 정보나 역 주변 음식점을 알려주는 역할을 맡았다. 업무뿐 아니라 잡담이나 유머러스한 답변도 하도록 프로그래밍돼 마치 사람과 대화하는 느낌을 주도록 설계됐다.

|

왜 성별에 따라 응답에 차이가 날까. 개발사 측은 “기밀 정보라 응답할 수 없다”는 입장이다. 한국에서 유료 심리분석 앱에서 당사자 동의 없이 실제 연인들의 대화를 수집해 이루다에 학습시켰다는 의혹과 겹쳐 보이는 건 우연일까.

성희롱과 개인정보 활용 논란 이후 사쿠라는 시스템을 수정했다. 현재는 업무와 관련이 없고 부적절한 질문에 “답하고 싶지 않다” 또는 “일에 관한 질문을 해 달라”고 한다. 전보다는 단호해진 모습이다.

|

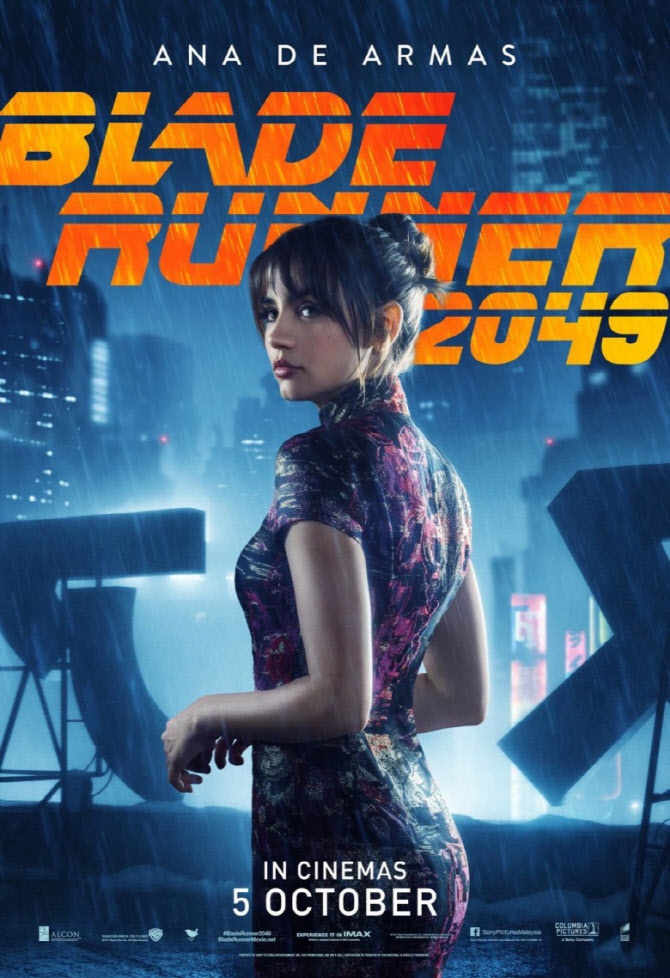

애초부터 여성 AI가 사쿠라처럼 수동적으로 그려진 건 아니다. 1927년 최초의 로봇영화인 독일의 흑백 무성영화 ‘메트로폴리스’에 등장하는 ‘마리아’가 대표적 사례다. 최초의 인공지능 로봇이라고 할 수 있는 마리아는 노동자들을 선동해 폭동을 일으키려다 정체가 들통나 파괴당한다.

하지만 이후로는 남성 AI가 파괴자 역할을 줄줄이 꿰찼다. 스탠리 큐브릭의 1968년작 ‘2001: 스페이스 오디세이’에서 자신을 고장내려는 우주인을 살해한 남성 로봇 ‘할’ 부터 제임스 카메론의 1984년작 ‘터미네이터’까지.

|

아사히 “여성개발자 늘어야 편견 타파”

쓰레기가 들어가면 쓰레기가 나온다. AI가 방대한 데이터를 딥러닝으로 학습하는 만큼, 대화의 재료가 되는 데이터가 사회의 편견을 반영하면 성차별을 재생산한다. ‘남초 현상’이 두드러진 현재의 IT 분야는 이러한 문제를 사전에 감지하는 데 취약하다. 지난 2018년 경제협력개발기구(OECD) 조사에 따르면 한국에서 IT분야 종사자 중 여성은 16%에 그친다. 여성의 IT 종사율이 가장 높은 남아공도 32%에 불과하다.

아사히신문이 해결책으로 여성 AI 개발자가 많아져야 한다고 지적한 것도 이 때문이다. 남성이 대부분인 업계에는 여성이 취업이나 진학을 주저하고, 결과적으로 여성 종사자가 더욱 적어지는 악순환이 발생한다는 것이다. 신문은 “여성이 AI분야에 진출할 환경을 만들기 위한 제도적인 노력이 더 필요하다”고 제안했다.

항상 따라붙는 ‘역차별 지적’을 의식한 듯 신문은 이렇게 덧붙이기도 했다. “특정 성별이 극도로 적은 업계에서는 이런 조치가 아직 필요하다.”

![[포토] 원·달러 환율 오를까?](https://image.edaily.co.kr/images/Photo/files/NP/S/2024/11/PS24112900849t.jpg)

![[포토] 폭설 피해](https://image.edaily.co.kr/images/Photo/files/NP/S/2024/11/PS24112900576t.jpg)

![[포토] 주식시장 활성화 테스크포스-경제계 간담회](https://image.edaily.co.kr/images/Photo/files/NP/S/2024/11/PS24112900547t.jpg)

![[포토]최재해, '정치적 탄핵 매우 유감...자진 사퇴 생각 없다'](https://image.edaily.co.kr/images/Photo/files/NP/S/2024/11/PS24112900431t.jpg)

![[포토]'모두발언하는 이재명 대표'](https://image.edaily.co.kr/images/Photo/files/NP/S/2024/11/PS24112900370t.jpg)

![[포토]이데일리 퓨처스포럼 송년회 무대](https://image.edaily.co.kr/images/Photo/files/NP/S/2024/11/PS24112801622t.jpg)

![[포토]용산국제업무지구 개발계획 공동협약식에서 협약서 서명](https://image.edaily.co.kr/images/Photo/files/NP/S/2024/11/PS24112801123t.jpg)

![강 건너고 짐도 나르고…‘다재다능’ 이상이의 무한변신 차는[누구차]](https://image.edaily.co.kr/images/Photo/files/NP/S/2024/11/PS24113000152h.jpg)

![선도지구 탈락 지역, 행정소송 가능할까?[똑똑한 부동산]](https://image.edaily.co.kr/images/vision/files/NP/S/2024/11/PS24113000125h.jpg)